随机梯度下降的新对数步长

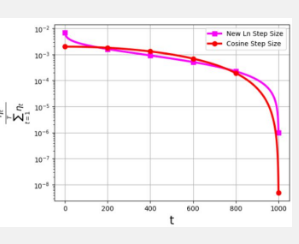

步长通常称为学习率,在优化随机梯度下降(SGD)算法的效率方面起着关键作用。近年来,出现了多种步长策略来增强 SGD 性能。然而,与这些步长相关的一个重大挑战与其概率分布有关,表示为 ηt/Σ T t=1 ηt 。观察这种分布是为了避免为最终迭代分配极小的值。例如,广泛使用的余弦步长虽然在实践中有效,但通过为最后迭代分配非常低的概率分布值来遇到这个问题。

为了应对这一挑战,由 M. Soheil Shamaee 领导的研究团队 于 2024 年 3 月 14 日在 高等教育出版社和 Springer Nature 联合出版的《计算机科学前沿》上发表了他们的新研究。

该团队为 SGD 方法引入了新的对数步长。事实证明,这种新的步长在最终迭代期间特别有效,与传统的余弦步长相比,它的选择概率明显更高。因此,新的步长方法在这些关键的结论迭代中超越了余弦步长方法的性能,这得益于它们被选为选定解决方案的可能性增加。获得的数值结果证明了新提出的步长的效率,特别是在 FashionMinst、CIFAR10 和 CIFAR100 数据集上。此外,新的对数步长在测试精度方面表现出显着的改进,与卷积神经网络 (CNN) 模型一起使用时,CIFAR100 数据集的精度提高了 0.9%。

免责声明:本答案或内容为用户上传,不代表本网观点。其原创性以及文中陈述文字和内容未经本站证实,对本文以及其中全部或者部分内容、文字的真实性、完整性、及时性本站不作任何保证或承诺,请读者仅作参考,并请自行核实相关内容。 如遇侵权请及时联系本站删除。